中国製AI「manus」の危険性について解説します

「最近話題のManus AIを使ってみたいけど、リスクはないのかな・・」

「勝手にAIが処理していくのはちょっと怖いけど・・大丈夫?」

そんな不安を抱えていませんか?

私も最初は、どんどん便利になっていくAIにワクワクしました。

しかし、利便性が増していく中で、心のどこかで不安も感じるようになりました。

あなたも、この不安やリスクをしっかりと把握しておかないと、思わぬ落とし穴にハマってしまうかもしれません。

特に「manus」のようなAIエージェントを扱うには、責任と知識が必要です。

ただ便利だからと、何も知らないまま使うのはちょっと待った方がいいかもしれません・・

そこで、この記事では、AIエージェントManus(マヌス)のリスクを丁寧に解説し、その裏にある本当の危険性を明らかにします。

さらに、安心して使うための具体的な対策もステップごとにお伝えします。

→【AIの力で作業負担ほぼ不要】自動運営ブログ機能(PAE)はコチラで紹介中

この記事を読むことで、manusを適切に扱えるようになり、安全かつAIエージェントの魅力を存分に体感することができます。

怖がるだけで終わらず、賢く使いこなす一歩を一緒に踏み出しましょう!

Manus AIの強みと”ヤバイ”と噂される理由

manusは多くの人に絶賛されているAIエージェントです。

ここではまず、ManusってどんなAIなの?という基本と、“やばい”と話題になる背景を見ていきましょう。

開発企業と技術の概要

Manus(マヌス)は、2025年に中国のAIスタートアップ「Monica」が開発した最新のAIエージェントです。

企業の親会社は「Butterfly Effect」という名前で、シンガポール法人という形をとってはいますが、開発の中心は中国にあるとされています。

名前も聞いたことない会社だけど大丈夫?って感じですね

ですが、Manusがすごいのは、その“技術力”がガチなこと。

AI業界で使われる「GAIAベンチマーク」という基準で、あのOpenAIの「Deep Research」を超えるスコアを叩き出しているんです。

このベンチマークとは、AIが「情報を集めて考えて、実行する」力を数値化するもの。

つまり、ただ会話するAIじゃなく、ちゃんと技術的にも“仕事ができるAI”ということです。

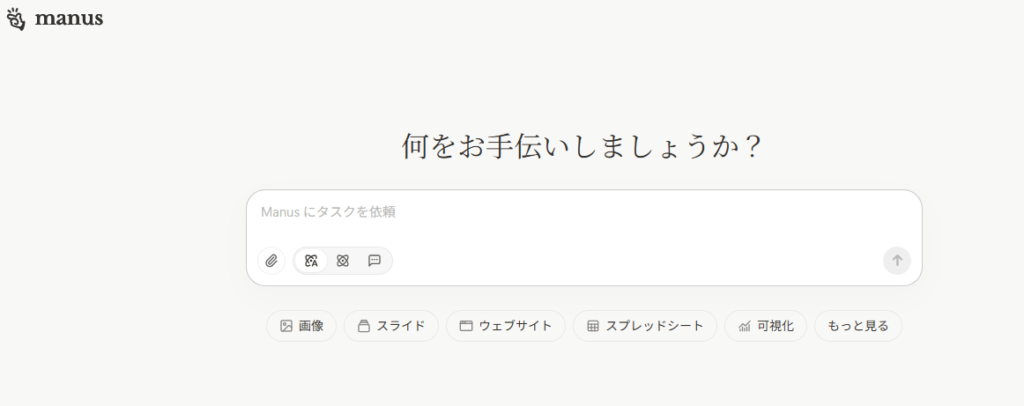

「こんなことまでやってくれるの?」が現実に

Manusが他のAIと違うのは、その“自律性”の高さ。

たとえば、あなたが「〇〇についてのWebサイト作って」って一言指示するだけで、

- 関連情報をネットから探して

- 構成を考えて

- テキストや画像を自動生成して

- レイアウトする

…っていう、まるでチームを1人でこなすスーパーアシスタントのような動きをしてくれます。

この自律型AIはChatGPTのエージェント機能やfeloにも通ずる機能ですね

この動き、エンジニアでなくても簡単に使えるのが魅力なんですが、逆に

「ここまでできるの!?」

と不安になる人も多いようです。

実際、Xでも

「もはや人間の仕事なくなるのでは…」

という声が上がっています。

AIはどんどん進化してイキマスヨー!

「やばい」って言われる背景【ポジティブとネガティブ】

Manusについて調べていると、「やばい」「危険」といったワードが目に付きます。

でも、これって全部が“悪い意味”ではありません。

たとえば、開発者界隈では

「GitHubのプロジェクトを自動で仕上げるManus、マジでやばい(=すごい)」

とポジティブな意味で話題になっています。

実際、ちょっとした命令でアプリの設計から公開までしてしまうという事例も出ています。

でもその反面、「こんなに自由に動けるAI、大丈夫なの?」という声も当然出てきます。

特に中国企業という点から

「データ持っていかれるんじゃ・・?」

「不正に利用されてしまうのでは?」

といった不安がSNSでも広まっています。

つまり、“やばい”という言葉が、ポジティブとネガティブという両極端な感情を表してるということです。

本当に危険?Manusのリスク4大ポイント

超便利そうに見えるManus。

でも、SNSやネット記事では

「危ない」

「情報漏洩のリスクがある」

といった声も…。

ここでは、実際に懸念されている4つのリスクについて、できるだけわかりやすく整理してみましょう。

地政学的リスク(中国の国家情報法とデータ提供義務)

まず最初に触れておきたいのが、「中国企業が作っている」という点です。

実はこれ、海外の専門家の間でもかなり議論を呼んでいます。

なぜなら中国には「国家情報法」という法律があるからです。

簡単に言うと

「中国政府が必要だと判断すれば、企業は持っているデータを提出しなければならない」

というもの。

国のルールでそうなっているので、企業ではどうしようもないですね

つまり、どんなに企業側が「私たちはプライバシーを守ります」と言っても、政府の要請があれば逆らえない…という構造があるんです。

Manusは表向きにはシンガポール法人のサービスとして提供されていますが、開発元であるMonica社やその母体企業が中国。

そのため、よからぬ憶測を生み、安全性に疑問を持つのは自然な反応です。

実際、アメリカではこの懸念を理由に、中国製AIの導入を制限する動きも出ています。

プライバシーの霧—利用規約・データ保存場所のあいまいさ

次に気になるのは、Manusのプライバシーポリシーやデータ管理の透明性です。

私自身も読んでみたのですが

・データの利用目的

・データはどこに保存されているのか

といった重要な情報が、かなりぼんやりしている印象を受けました。

たとえば、「ユーザーデータはサービス改善のために使用されることがあります」といった表現は、どこのAIサービスにもあるものです。

しかし、Manusの場合は「どの情報が、どこで、誰に見られる可能性があるのか」が不明瞭です。

さらに、データが中国のサーバーで処理されている可能性も指摘されていますが、それについて明確な説明はありません。

つまり、何気なく入力した情報が、どこかで誰かに“見られているかもしれない”という状況を完全には否定できないということです。

なんだかモヤモヤしている状態デスネ・・・

自律性ゆえのセキュリティ誤動作リスク

Manusの魅力であり、同時にリスクでもあるのがその“自律性”。

たった一つの指示で、AIが勝手に情報を集め、コードを書く——。

これ、使い方によってはとても便利ですが、同時に「何をしているのか把握できない怖さ」もあります。

たとえば、

- AIが外部の悪意あるプロンプトを解釈する

- 実は指示されていない内容を実行している

…など、ユーザーが気づかないうちに、セキュリティリスクが生まれる可能性があるんです。

しかも、AIがその原因を説明してくれるわけではないので、気づいた時には手遅れ…というケースも。

実際、ファイアウォール設定の誤認識によりシステムが外部に開放されたという事例も報告されています。

基本は仮想で行っている・・ハズなので大丈夫・・だと思いますが

これは、AIが“賢すぎる”がゆえに起きてしまう、想定外なリスクです。

manus開発体制の透明性(登記所在地と実際の開発拠点のズレ)

最後に、運営企業の透明性にも触れておきましょう。

先にも解説したように、公式サイトでは「シンガポール法人」として運営されていると書かれていますが、実際の開発チームは中国本土にあるとされています。

このような「登記上の所在地」と「実態としての開発拠点」が異なるケースは、利用者から見ると非常に判断が難しい問題です。

なんでわざわざ別にするのか・・色々気になっちゃいマス

なぜなら、トラブルの際にどこの法律が適用されるのか、どこに責任を問えばいいのかが曖昧になるからです。

実際に専門家の中には、こうした構造を「法的な偽装に近い」と批判する声もあります。

このように、たとえ技術力が高くても、運営の背景が不透明なままでは、安心して使えるとは言いづらいのが正直なところです。

AI初心者向け!Manusを安全に使う5つのルール

便利なものほどリスクを把握して、正しい“使い方”を知っておくことが大切です。

ここでは、初心者でも安心してManusを試せる5つのルールをご紹介します。

①“機密性の高い情報”を入力しない

ManusのようなAIエージェントを使うとき、一番最初に心がけてほしいのが、「機密性の高い情報は絶対に入力しない」ことです。

リスクでも説明したように、情報がどのような形で流用されるか分からないからです。

たとえば

- 自分の本名、住所、電話番号

- クレジットカード情報

- 仕事の取引先に関する情報

- 社外秘の資料や社内戦略

これらは絶対にNGです。

まずは、公開されているニュース記事の要約や、個人ブログ用の文章構成など、失っても問題ない情報でManusの使い心地を試してみましょう。

manusは便利なツールですが、入力した情報がどこにどう使われるか完全にはコントロールできないのが現状です。

だからこそ、最初は“お試し”程度に留めるのが安全です。

②使い捨てアカウント&サンドボックス環境で試す

「ちょっと高度なタスクも試してみたい」

そんな時は、社内ネットワークとは切り離された仮想環境(サンドボックス)で利用しましょう。

また、登録が必要な場面では、メインのGoogleアカウントや会社のメールではなく、“使い捨てアカウント”を使うのがおすすめです。

できれば専用の仮想マシン(VM)や別のPCを用意して、隔離された状態で使うのが理想的です。

こうすることで、万が一Manusが悪意のあるサイトにアクセスしたり、外部に通信を送ったりしても、影響を最小限に抑えることができます。

「最悪を想定した備え」が、安心してAIを楽しむカギです。

③AIのアウトプットは必ず人間がチェック!

AIの出力結果って、ぱっと見は「おお、完璧!」って思うこともありますよね。

でも、それをそのまま使うのはとても危険です。

特にManusのような“自律型AI”は、情報を自動収集・自動生成してしまうため、

- 古い情報を引用している

- 間違った事実を断定して書いている

- 引用元が曖昧、あるいは存在しない

…といったことが平気で起きます。

だからこそ、AIが出した結果は「下書き」として受け取り、人間の目でしっかりレビューすることが大事です。

「この内容、本当に正しいのかな?」

「この言い方、なんか日本語的に変じゃないかな?」

と一歩立ち止まって確認するクセをつけましょう。

④データ管理の基本を“今すぐ”見直す

Manusを使うかどうかに関わらず、「情報の扱い方」は今後ますます重要になります。

特に気をつけたいのは以下のようなポイント。

- どんな情報をどのAIに入力したかを記録する

- 使い終わったアカウントやデータはすぐに削除する

- 社内の共有フォルダやクラウドに重要ファイルを放置しない

- 通信は必ず暗号化(https)されているか確認する

これらは当たり前のようで、意外と見落とされがちです。

基本に立ち返るつもりで一度確認を

今一度、自分の環境を見直して、「AI時代の情報管理」に慣れておくと、いざという時に慌てずに済みます。

⑤法律とガイドラインを“味方”にする

AIを使うとき、”自分だけが利用してる分にはOK”という問題じゃないことに注意です。

なぜなら、著作権や商法利用など法律に抵触する可能性があるからです。

たとえば、Manusを使って作った文章や資料が、もし誰かの権利を侵害していたら…?

トラブルになりかねません。

これ以外にも現在、日本では

・個人情報保護法

・不正アクセス禁止法

・GDPR(欧州のデータ保護規則)

など、AIの使い方に影響する法律が多数あります。

「なんだか難しそう…」と思ったら、まずは会社や自治体が出しているAI利用ガイドラインをチェックしてみましょう。

自分が守るべきルールを知っておけば、トラブルを防ぐだけでなく、安心して活用する自信にもつながります。

AIエージェントはmanus以外にもある

ここまでManusを中心に解説してきましたが、AIエージェントはManusだけではありません。

あなたのリスク許容度によって、利用するAIの最適解は変わります。

ここでは、ChatGPTのエージェントモードと、日本発のFeloを取り上げ、特徴と安全面を比較します。

ChatGPTのエージェントモード(OpenAI)

ChatGPTには、外部サービスと連携して半自律的にタスクを進められる「エージェントモード」が用意されています。

認証したコネクタ(メール、カレンダー、ドライブ等)へアクセスし、予定の要約や資料検索、下書き作成などを実行可能。

実行時はブラウザを引き継いでログインを促すなど、ユーザー側で確認しながらアクションさせる設計で、フル自動よりも制御性と安心感を優先しています。

【強み】

・既存ワークフローと連携しやすい

・人が最終確認しやすい構造

【注意点】

・完全放任の自動化ではないため、自律性はあっても用途は限定的(機能は順次拡張中)

・主要プラン(Plus/Team/Enterprise等)で利用可能

(補足)OpenAIの公式発表では、エージェントはユーザーが認可したコネクタにアクセスし、必要時はブラウザでログインを促す方式と明記されています。安全側に倒したオペレーション設計が特徴です。

Felo(フェロ) 日本発の検索×要約エージェント

Feloは日本のスタートアップ「Felo株式会社」(本社:東京)が開発・運営する、検索と要約に強いマルチリンガルのAI検索エージェントです。

自然文で質問すると、信頼できる複数ソースから回答を生成し、参照元を明示してくれるのが大きな安心材料。

レポート・スライド・マインドマップ・ポスターの自動生成など、「調べる→まとめる→形にする」までを一気通貫で支援します。

【強み】

・多彩な機能(リアルタイム検索/出典付き回答/検索エージェント/ドキュメント出力)

・無料登録&日本語に最適化

【注意点】

・機能をフル活用するには課金が必要

AIエージェントでお金稼ぎはまだ厳しい現実

より便利になっていくAI。

どうせなら、上手に副業などの収入につなげたいですよね。

「AIエージェントを使って副業収入を得たい!」

そんな可能性を求めて、私もあれこれ模索してきました。

しかし現実には、現時点でAIを完全に活用して安定収益を得るのはまだ難しいのが実情です。

ここではその理由と今後の展望について解説します。

なぜ今は収益化が難しいのか?

AIエージェントの可能性は無限大ですが、収益化の壁はいくつも存在します。

- リスク管理の難しさ

- 自律性が高いAIほど誤動作やセキュリティリスクが増え、ビジネス利用には監督が不可欠。

- 品質の担保が必要

- AIの出力はまだ人のチェックを外せず、完全自動で収益を生むには限界がある。

- 市場が未成熟

- 制度や法整備が追いつかず、安心して商用利用できる仕組みが整っていない。

このように、必ず人の手を加える必要があるため、完全自動で任せてお金を生み出し続けるというわけにはいかないのが現状です。

一部で、AIエージェントを活用してブログ記事やコンテンツ制作を収益につなげている事例もありますが、これは人がレビュー・最適化を行って初めて成立するモデル。

自律型に頼った収益化モデルは、品質低下や信用棄損のリスクを招きやすいです。

作業量を限りなく削って収益化できるツールはある

そこで注目されているのが、次世代の自動化ツール「PAE(Phoenix Auto Engine)」です。

これは、収益化に特化させた安全設計と拡張性を持ち合わせている点が大きな特徴です。

- 安全な自動化

- AIの行動を制御しつつ、運営を自動化させる

- 人が介在しやすい設計

- 処理の修正・中断が可能で、カスタマイズも柔軟。

- 収益性に特化

- ブログ機能&マネタイズの仕組みを意識した設計。

AIで「お金を稼ぐ」のはまだ簡単ではありません。

しかし、PAEのような収益性を重視した新しい仕組みで、AI活用×マネタイズが実現します。

AIの機能を収益化に全振りさせ、安全性も担保した現代のツールをチェックしてみてください。

→Phoenix Auto Engine(PAE)の詳しい解説はこちら

manusの危険性を知った上で活用を【まとめ】

ここまで読んでくださったあなたなら、Manusの“すごさ”と“危うさ”、両方をしっかり理解できたはず。

最後に、要点を簡単に振り返りながら、これからどう行動すればいいか、一緒に整理していきましょう。

- Manusは中国発の革新的なAIエージェントで、ユーザーの指示をもとにタスクを自律的にこなせる。

- ただし地政学的リスク(国家情報法)やプライバシーの不透明さなど、明確なリスクも存在する。

- 自律性の高さが裏目に出ると、セキュリティ事故や情報流出の可能性もあるため、使い方には要注意。

- 初心者が安全に活用するためには「機密情報は入れない」「人間がチェックする」「法律を理解する」ことが大事。

- AIエージェントで完全自動収益化は現状厳しい

便利でパワフルなManusだからこそ、リスクを承知した上で“正しく使う”という姿勢が求められます。

でも難しく考える必要はありません。

manusだけでなくAIエージェントを使う場合は

- 使い捨てアカウントやサンドボックスを試して、リスクのない環境を整えてみる

- 社内・家庭で「AIを使うときのルール」を話し合ってみる

- 信頼できるガイドラインや法制度について、軽く調べてみる

これらはすべて、AIとうまく付き合うためのコツです。

AIは、使い方ひとつで「毒」にも「薬」にもなる時代。

だからこそ、Manusのような高性能AIを前にしたとき大切なのは“怖がること”ではなく、“理解して、使いこなすこと”。

今後もAIに対する知識を深め、リスクヘッジに必ず取り組むようにしましょう。

(追伸)AIスキルは収益につなげない理由がない

Sora2に興味があるのなら、収益につなげる思考も合わせて身に着けませんか?

AI市場はものすごい勢いで成長しており、私たちの日常に浸透しつつあります。

「動画生成には興味があるけど、収益化につなげる方法はわからない」

ソレ、もったいないです・・・

そこで、一度“着実に収益につなげる思考”をメルマガで身に着けませんか?

私の無料メール講座では、ゼロから副業の収益化を目指す具体ステップを数日に分けて配信。

副業も”知るだけ”ではお金になりません。

そのため、メール講座では”収益化の核となる考え方”を押さえつつ、0から着実に成果を出せる人とそうでない人を、具体例を交えながら配信しています。

とりあえず知っておくだけでも損はないカト・・

また、登録者特典として、計30,000字超PDFと動画も無料でプレゼントしています。

登録は約15秒・いつでも解除OK。

今日の学びを“収益化の流れ”へつなげませんか?

【AI副業無料メール講座はコチラ】

登録特典「【初成果までのハードルがグッと下がる】AI時代の副業マインドセット」

(計30000字超の動画と資料のプレゼント)

※メール最後の解除リンクで、すぐに解除できます。

※携帯やiCloudは到達しません。gmail/ヤフー/プロバイダーメールをご使用ください。

※捨てアドレスは自動削除しています(特典配布されません)。

※個人情報はプライバシーポリシーに基づき、厳正に管理します。

※迷惑メールチェック&受信設定をお願いします(特典が受け取れません)